Big Data

Big Data, en el sector de las TIC’s es una referencia a los sistemas que manipulan grandes conjuntos de datos. Las dificultades más habituales en estos casos se centran en la captura, el almacenado, búsqueda, compartición, análisis, y visualización. La tendencia a manipular ingentes cantidades de datos se debe a la necesidad en muchos casos de incluir los datos relacionados del análisis en un gran conjunto de datos relacionado, tal es el ejemplo de los análisis de negocio, los datos de enfermedades infecciosas, o la lucha contra el crimen organizado.

Definición:

“Big data” es un término aplicado a conjuntos de datos que superan la capacidad del software habitual para ser capturados, gestionados y procesados en un tiempo razonable. Los tamaños del “big data” se hallan constantemente en aumento. En 2012 se dimensionaba su tamaño en una docena de terabytes hasta varios petabytes de datos en un único data set.

En 2001, en un informe de investigación que se fundamentaba en congresos y presentaciones relacionadas,el analista Doug Laney definía el crecimiento constante de datos como una oportunidad y un reto para investigar en el volumen, la velocidad y la variedad. Grandes proveedores del mercado de big data están desarrollando soluciones para atender las demandas más críticas de procesamiento de datos masivos, como MapR, Cyttek Group y Cloudera.

¿De dónde proviene toda esa información?

Los seres humanos estamos creando y almacenando información constantemente y cada vez más en cantidades astronómicas. Se podría decir que si todos los bits y bytes de datos del último año fueran guardados en CD’s, se generaría una gran torre desde la Tierra hasta la Luna y de regreso.

Esta contribución a la acumulación masiva de datos la podemos encontrar en diversas industrias, las compañías mantienen grandes cantidades de datos transaccionales, reuniendo información acerca de sus clientes, proveedores, operaciones, etc., de la misma manera sucede con el sector público. En muchos países se administran enormes bases de datos que contienen datos de censo de población, registros médicos, impuestos, etc., y si a todo esto le añadimos transacciones financieras realizadas en línea o por dispositivos móviles, análisis de redes sociales (en Twitter son cerca de 12 Terabytes de tweets creados diariamente y Facebook almacena alrededor de 100 Petabytes de fotos y videos), ubicación geográfica mediante coordenadas GPS, en otras palabras, todas aquellas actividades que la mayoría de nosotros realizamos varias veces al día con nuestros “smartphones”, estamos hablando de que se generan alrededor de 2.5 quintillones de bytes diariamente en el mundo.

¿Qué tipos de datos debo explorar?

Muchas organizaciones se enfrentan a la pregunta sobre ¿qué información es la que se debe analizar?, sin embargo, el cuestionamiento debería estar enfocado hacia ¿qué problema es el que se está tratando de resolver?.

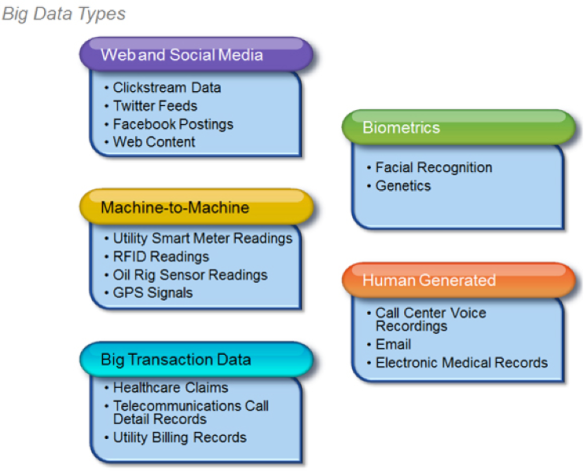

Si bien sabemos que existe una amplia variedad de tipos de datos a analizar, una buena clasificación nos ayudaría a entender mejor su representación, aunque es muy probable que estas categorías puedan extenderse con el avance tecnológico.

1.- Web and Social Media: Incluye contenido web e información que es obtenida de las redes sociales como Facebook, Twitter, LinkedIn, etc, blogs.

2.- Machine-to-Machine (M2M): M2M se refiere a las tecnologías que permiten conectarse a otros dispositivos. M2M utiliza dispositivos como sensores o medidores que capturan algún evento en particular (velocidad, temperatura, presión, variables meteorológicas, variables químicas como la salinidad, etc.) los cuales transmiten a través de redes alámbricas, inalámbricas o híbridas a otras aplicaciones que traducen estos eventos en información significativa.

3.- Big Transaction Data: Incluye registros de facturación, en telecomunicaciones registros detallados de las llamadas (CDR), etc. Estos datos transaccionales están disponibles en formatos tanto semiestructurados como no estructurados.

4.- Biometrics: Información biométrica en la que se incluye huellas digitales, escaneo de la retina, reconocimiento facial, genética, etc. En el área de seguridad e inteligencia, los datos biométricos han sido información importante para las agencias de investigación.

5.- Human Generated: Las personas generamos diversas cantidades de datos como la información que guarda un call center al establecer una llamada telefónica, notas de voz, correos electrónicos, documentos electrónicos, estudios médicos, etc.

The best open source big data tools

Apache Hadoop

When people say “big data” or “data science,” they’re usually talking about a Hadoop project. Hadoop generally refers to the MapReduce framework, but the project also consists of important tools for data storage and processing. This new YARN framework, aka MapReduce 2.0, is an important step forward for Hadoop, and you can expect a big hype cycle to start shortly (if not then I’ll start one!).

There aren’t many Apache projects that support even one heavily capitalized startup. Hadoop supports several. Analysts estimate that Hadoop will be a ballooning market worth tens of billions per year. If you slipped into a coma during the financial crisis and just woke up, this is the biggest thing you missed.

— Andrew C. Oliver

Apache Sqoop

When you think of big data processing, you think of Hadoop, but that doesn’t mean traditional databases don’t play a role. In fact, in most cases you’ll still be drawing from data locked in legacy databases. That’s where Apache Sqoop comes in.

Sqoop facilitates fast data transfers from relational database systems to Hadoop by leveraging concurrent connections, customizable mapping of data types, and metadata propagation. You can tailor imports (such as new data only) to HDFS, Hive, and HBase; you can export results back to relational databases as well. Sqoop manages all of the complexities inherent in the use of data connectors and mismatched data formats.

— James R. Borck

Talend Open Studio for Big Data

Talend Open Studio for Big Data lets you load files into Hadoop (via HDFS, Hive, Sqoop, and so on) without manual coding. Its graphical IDE generates native Hadoop code (supporting YARN/MapReduce 2) that leverages Hadoop’s distributed environment for large-scale data transformations.

Talend’s visual mapping tools allow you to build flows and test your transforms without ever getting your hands dirty with Pig. Project scheduling and job optimization tools further enhance the toolkit.

Gleaning intelligence from big piles of data starts with getting that data from one place to Hadoop, and often from Hadoop to another place. Talend Open Studio helps you swim through these migrations without getting bogged down in operational complexities.

— James R. Borck

Apache Giraph

Apache Giraph is a graph processing system built for high scalability and high availability. The open source equivalent of Google’s Pregel, Giraph is used by Facebook to analyze social graphs of users and their connections. This system circumvents the problem of using MapReduce to process graphs by implementing Pregel’s more efficient Bulk Synchronous Parallel processing model. The best part: Giraph computations run as Hadoop jobs on your existing Hadoop infrastructure. You get distributed graph processing while using the same familiar tools.

— Indika Kotakadeniya

Apache Hama

Like Giraph, Apache Hama brings Bulk Synchronous Parallel processing to the Hadoop ecosystem and runs on top of the Hadoop Distributed File System. However, whereas Giraph focuses exclusively on graph processing, Hama is a more generalized framework for performing massive matrix and graph computations. It combines the advantages of Hadoop compatibility with a more flexible programming model for tackling data-intensive scientific applications.

— Indika Kotakadeniya

Cloudera Impala

What MapReduce does for batch processing, Cloudera Impala does for real-time SQL queries. The Impala engine sits on all the data nodes in your Hadoop cluster, listening for queries. After parsing each query and optimizing an execution plan, it coordinates parallel processing among the worker nodes in the cluster. The result is low-latency SQL queries across Hadoop with near-real-time insight into big data.

Because Impala uses your native Hadoop infrastructure (HDFS, HBase, Hive metadata), you get a unified platform where you can analyze all of your data without connector complexities, ETL, or expensive data warehousing. And because Impala can be tapped from any ODBC/JDBC source, it makes a great companion for BI packages like Pentaho.

— James R. Borck

Serengeti

VMware’s project aimed at bringing virtualization to big data processing, Serengeti lets you spin up Hadoop clusters dynamically on shared server infrastructure. The project leverages the Apache Hadoop Virtualization Extensions — created and contributed by VMware — that make Hadoop virtualization-ready.

With Serengeti, you can deploy your Hadoop cluster environments in minutes without sacrificing configuration options like node placement, HA status, or job scheduling. Further, by deploying Hadoop in multiple VMs on each host, Serengeti allows data and compute functions to be separated, improving computational scaling while maintaining local data storage.

— James R. Borck

Video:

Explaining Big Data

Conclusiones

La naturaleza de la información hoy es diferente a la información en el pasado. Debido a la abundacia de sensores, micrófonos, cámaras, escáneres médicos, imágenes, etc. en nuestras vidas, los datos generados a partir de estos elementos serán dentro de poco el segmento más grande de toda la información disponible.

El uso de Big Data ha ayudado a los investigadores a descubrir cosas que les podrían haber tomado años en descubrir por si mismos sin el uso de estas herramientas, debido a la velocidad del análisis, es posible que el analista de datos pueda cambiar sus ideas basándose en el resultado obtenido y retrabajar el procedimiento una y otra vez hasta encontrar el verdadero valor al que se está tratando de llegar.

Referencias

http://es.wikipedia.org/wiki/Big_data

http://mexico.emc.com/campaign/bigdata/index.htm

http://www.cnnexpansion.com/opinion/2013/01/17/por-que-la-innovacion-es-tan-dificil

– Marevna Reséndiz

– Patricia Sagahón

– Alberto Montes Avila

Un aspecto primordial para ingresar al mundo de Big Data, es saber cómo afrontarlo. Un artículo de la revista Harvard Business Review “Big data: the management revolution”, menciona 5 líneas a considerar:

1) Liderazgo: contar con un buen líder que detecte las oportunidades de negocio, con capacidad de establecer metas claras.

2) Gestión de talento: un nuevo perfil de profesionista denominado “científicos de datos”, será necesario en los equipos interdisciplinarios de este tipo de proyectos.

3) Tecnología: gran parte del software para llevar esto acabo es de código abierto.

4) Toma de decisiones: una organización eficaz deberá poner información y toma de decisiones al mismo nivel.

5) Cultura empresarial: la organización deberá pasar del ¿qué pensamos? al ¿qué sabemos? y alejarse de la toma de decisiones basada en impulsos e instintos.

Liga del artículo:

http://hbr.org/2012/10/big-data-the-management-revolution/ar/4

Hace tiempo en la Organización en la que trabajaba nos impartieron cursos de “Minería de Datos”, que venía a ser algo parecido, explorar en los datos buscando valor. Entonces era un campo estratégico, pues al aumentar en las empresas la rotación de empleados se decía que se sufría una pérdida de conocimiento cada vez que un empleado se iba puesto que los conocimientos sobre el negocio se iban con él.

Se deseaba conservar información sobre los clientes, opinión del mercado sobre los productos, etc., por lo que era necesario que las máquinas aprendieran a extraer el conocimiento existente de cualquier fuente de información de la empresa, no solo en pedidos, facturas y estadísticas de venta, sino en correos electrónicos y todo tipo de documentos no estructurados, como informes, mensajería instantánea, etc. de modo que al menos una parte de la información se conservará como un activo de valor.

Big Data es un proyecto sumamente prometedor, sacar valor de cerros de información heterogénea que generamos día con día, al final el Datamining y Big Data son herramientas de análisis de información que bien implementadas podrían generar mucho valor a las organizaciones.

Gracias, Giovanni, por compartir el artículo. El blog creo que se enfocó a la definición de BigData, entender de dónde salen los grandes volúmenes de información, presentar algunas herramientas “open source” y ofrecer una conclusión queme hizo pensar en una profesión en la que no dejo de pensar; “Científico de Datos”, que está empezando a ser demandada en el mundo y que me hace pensar en las opciones que tenemos las actuales y nuevas generaciones. Creo que cambio de idioma dentro del Blog no beneficio mucho. Saludos!

En lo particular el tema de Big Data creo que es un diamante en bruto en México, más allá del uso que se le da con enfoque a la investigación y a nivel empresarial, creo que puede ser una herramienta para realizar estudios interesantes que nos aporten en general al desarrollo del país, de primera instancia se me ocurre el de utilizarlo para determinar patrones predictivos que nos ayuden a determinar el por qué el bajo nivel de educación en las escuelas públicas, así como determinar porque en ciertas zonas existe mayor deserción de alumnos. Creo que si se conocieran estos patrones de comportamiento, se podría mejorar este sector en el país.

Hay muchos lugares desde donde podemos inyectar información hacia las empresas que puedan almacenarla de diferentes formas como son sensores, y es por eso que ahora Cisco tiene el concepto del internet de las cosas, en donde todo lo que haya en nuestro entorno puede darnos información personalizada, es decir que pudiera ser que un árbol al cual eres alérgico te dijera “no te acerques porque yo sé que tú eres alérgico a mi” es algo realmente interesante y que como podríamos pensar que es extremandamente caro, con el paso del tiempo y la reducción de cosos que hay en el silicón para fabricar las tarjetas, esto se hace cada vez más aclanzable y de facil producción.

Creo que esto es una parte importante del concepto de big data el cual estoy viviendo en el trabajo.

Me gustó la “clasificación” que muestran por tipo de Big Data, ya que son bastantes las fuentes de información que proveen de datos.

Para ampliar al tema de seguridad bancaria antifraudes, se están implementado estrategias de protección que permiten analizar y auditar grandes volúmenes de información, utilizando Big Data. Según datos de Gartner, se ha incrementado en un 30% los consumidores que declaran haber sido víctima de algún tipo de fraude.